|

|

|

|

|

机器人Emo提前0.9秒预测人类微笑,与人同时表达 |

|

|

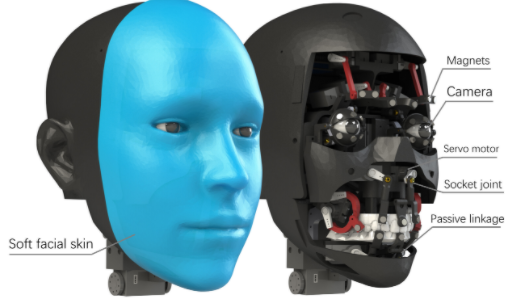

·Emo的眼睛里装有摄像头,蓝色柔性硅胶皮肤下有26个电机,类似于人类面部的肌肉,为机器人做出表情提供动力。它可以在人类微笑前839毫秒预测即将到来的微笑,并与人类同时表达微笑。Emo还可以预测悲伤、愤怒和惊讶等表情。

大模型让机器人的语言交流快速发展,但非语言交流却没有跟上。现在,哥伦比亚大学的研究人员开发了一款机器人,可观察人的面部表情,通过人脸的微小变化提前0.9秒预测人的微笑表情,并报以微笑。相关研究3月27日发表在《科学机器人》(Science Robotics)上。

人工智能可以模仿人类语言,但机器人还无法复制复杂的非语言线索和对交流至关重要的言谈举止。人形机器人可以依靠声音来交流,但通过脸部活动来表达面临双重挑战,一方面,驱动一个表情灵活丰富的机器人面孔在物理上具有挑战性,另一方面,要知道生成什么样的表情,使机器人看起来真实、自然、及时。

Emo使用人工智能模型和高分辨率相机预测人的面部表情并试图复制。

哥伦比亚大学研究人员提出可以通过训练机器人预测未来的面部表情并与人类同时执行这些表情来减轻这两个障碍。哥伦比亚大学机械工程系创新机器实验室教授霍德·利普森(Hod Lipson)团队开发了名为Emo的机器人,它使用人工智能模型和高分辨率相机预测人的面部表情并试图复制。

研究人员表示,该机器人可以在人类微笑前839毫秒预测即将到来的微笑,并通过模型与人类同时表达微笑。论文第一作者、哥伦比亚大学创新机器实验室博士Yuhang Hu介绍,例如在微笑完全形成之前,有一小段时间嘴角会开始上扬,眼睛会开始微微皱起。Emo可以捕捉到人们脸上的这些微小变化来预测面部表情。研究人员使用一个包含26个自由度的机器人面部来展示这种能力。

机器人包含26个电机并使用位置控制。3个电机控制颈部在三个轴上的运动。12个电机控制上脸,包括眼球、眼睑和眉毛。11个电机控制嘴部和下颚。

Emo的眼睛里装有摄像头,蓝色柔性硅胶皮肤下有26个电机,类似于人类面部的肌肉,它们为机器人的面部表情提供动力。其中,3个电机控制颈部在三个轴上的运动。12个电机控制上脸,包括眼球、眼睑和眉毛。11个电机控制嘴部和下颚。该机器人使用两个神经网络,一个用来观察人脸并预测表情,另一个研究如何在机器人脸上产生表情。第一个神经网络通过视频网站上的视频进行训练,第二个神经网络让机器人通过实时摄像机观看自己做的表情来训练。

“当它拉扯所有这些肌肉时,它知道它的脸会是什么样子。”利普森说,“这有点像一个人对着镜子,即使闭上眼睛微笑,也知道自己的脸会是什么样的。”

研究人员希望这项技术能让人机互动更逼真。他们认为,机器人必须先学会预测和模仿人类的表情,然后才能发展到更自发、更自我驱动的表达性交流。

除了微笑,Emo还可以预测悲伤、愤怒和惊讶等表情。但Emo还不能做出人类的所有表情,因为它只有26块面部“肌肉”。未来,研究人员还需要拓宽机器人的表情范围,他们也希望训练机器人对人所说的话做出反应,而不是简单模仿另一个人。此外,研究人员正利用大模型将语言交流整合到Emo中,让Emo能够回答问题和对话。

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。